传统大模型的“野路子学习法”

以前的大模型,学习方式只有“刷题”。像个天赋极高却不按常理出牌的学生:不背单词、不记公式、不认人名地名,全靠刷海量数据练“手感”。问它复杂推理题要耗算力,问“巴黎是哪国首都”这种常识题,照样要层层计算硬猜,既费钱又容易错。

核心问题很简单:大模型没有专门的“记忆区域”,只能把所有知识硬塞进“做题手感”里,用昂贵的GPU算力反复打磨,把该“背诵”的内容,硬生生变成了“计算”任务。

Engram:给大模型装“专属记忆区”

Engram的核心突破,是帮大模型分清了“背书”和“做题”:把人名、固定搭配、常识短语这些“静态知识”,放进专门的记忆结构里;而推理、推导这些“动态任务”,留给模型主干专心处理。

这套记忆不是死记硬背,还自带“智能开关”——会根据当前上下文筛选知识,比如遇到“苹果”,能分清是水果还是品牌,避免乱输出。就像人类先背会乘法口诀,再专心解数学题,效率自然翻倍。

与MoE互补:找到最优“精力分配”

可能有人会问,这和MoE技术有啥区别?MoE是解决“少算”,把模型拆成多个“专家”,按需激活减少算力消耗;而Engram是解决“别瞎算”,把该记的交给低成本记忆模块,让GPU聚焦核心推理。

论文还给出了“黄金比例”:7-8成参数留给推理专家,2-3成分配给Engram记忆模块,这是效率最高、性能最强的配置,实测中文常识任务CMMLU涨4分,逻辑推理BBH涨5分,长文本准确率直接飙升至97%。

工程巧思:CPU替GPU“存记忆”,成本大减

Engram更绝的是工程优化:把不常用的“潜意识记忆”放到便宜的CPU内存里,不用占用昂贵的GPU显存,只有需要时再调用。这种“查算分离”的操作,让大模型部署成本直接砍90%,以前要几万美金的算力,现在一千多美元就能搞定。

就像人类思考的节奏:思考-回忆-再思考,CPU负责“翻记忆手册”,GPU同步“解难题”,互不耽误,推理又快又省。

结语:AI记忆革命才刚开始

Engram不是给模型外接知识库,而是把“记忆”刻进大模型的核心结构,终结了“用推理算力硬刷常识”的低效模式。继MoE解决规模问题后,这是AI在“拟人化学习”上的关键一步。

如今基于V3.X的测试已如此能打,从头训练的V4又会带来多少惊喜?评论区聊聊你对AI“记忆进化”的期待~

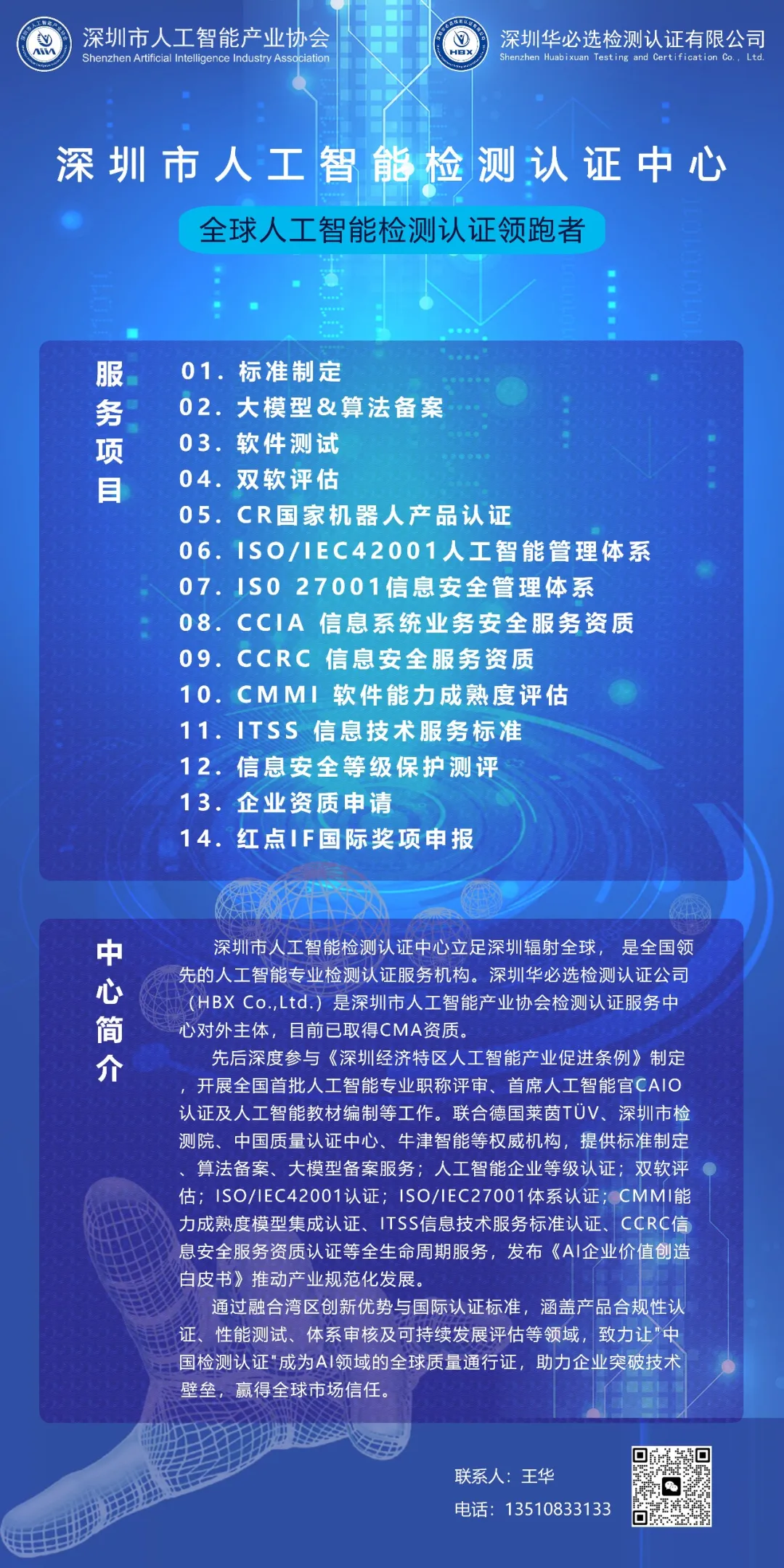

深圳市人工智能检测认证中心立足深圳辐射全球, 是全国领先的人工智能专业检测认证服务机构。深圳华必选检测认证公司(HBX Co.,Ltd.)是深圳市人工智能产业协会检测认证服务中心对外主体,先后深度参与《深圳经济特区人工智能产业促进条例》制定,开展全国首批人工智能专业职称评审、首席人工智能官CAIO认证及人工智能教材编制等工作。